以前設定したつもりになってたけど、実は設定されてなかったufwをインストールから順を追って記録

ufwというのは実はiptablesのラッパー機能になっていて、見え方をわかりやすくしたものと思えば良いのでしょうね

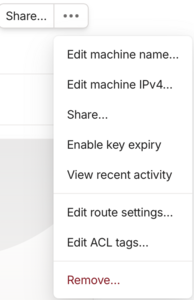

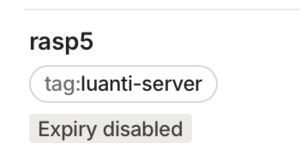

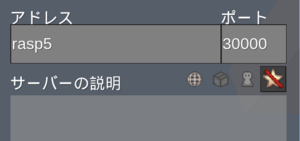

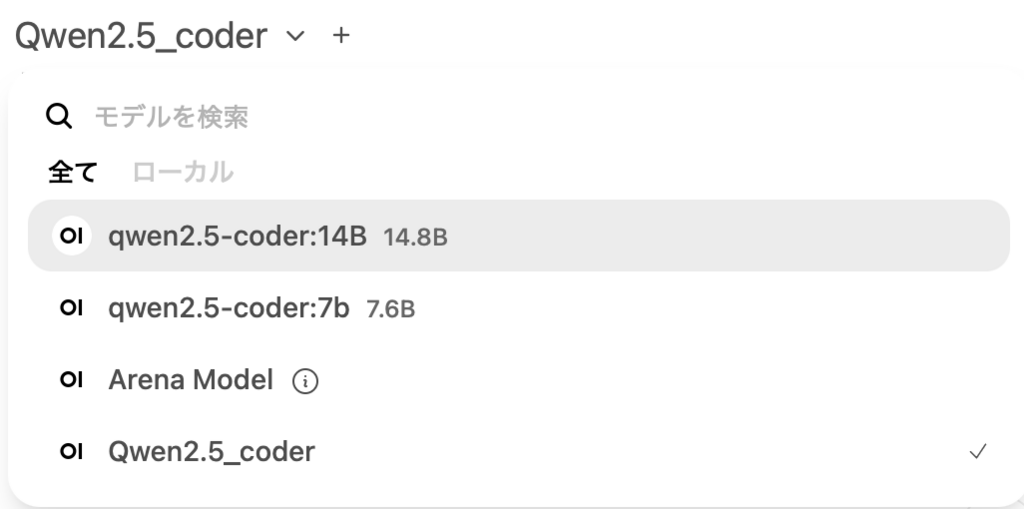

インストールから設定までのコマンドの使い方、tailscaleでの限定開放の例です、この様に指定するとLAN内の接続要求はリジェクトされます

$ sudo apt install ufw -y

ポート解放設定

$ sudo ufw allow in on tailscale0 to any port 22 proto tcp

$ sudo ufw allow in on tailscale0 proto tcp to any port 5900:5910

$ sudo ufw default deny incoming

$ sudo ufw default allow outgoing

$ sudo ufw enable // set to active

$ sudo ufw status

Status: active

To Action From

-- ------ ----

22/tcp on tailscale0 ALLOW Anywhere

5900:5910/tcp on tailscale0 ALLOW Anywhere

22/tcp (v6) on tailscale0 ALLOW Anywhere (v6)

5900:5910/tcp (v6) on tailscale0 ALLOW Anywhere (v6)

$ sudo ufw status numbered

Status: active

To Action From

-- ------ ----

[ 1] 22/tcp on tailscale0 ALLOW IN Anywhere

[ 2] 5900:5910/tcp on tailscale0 ALLOW IN Anywhere

[ 3] 22/tcp (v6) on tailscale0 ALLOW IN Anywhere (v6)

[ 4] 5900:5910/tcp (v6) on tailscale0 ALLOW IN Anywhere (v6) 不要なルールの削除

$ sudo ufo delete n(番号、複数削除するときは上位番号から削除する若い番号から消すと順序が乱れるだろうから、最上位側から消すのが普通と思う

サーバーであればポート開放を限定的にするのはほぼ必須です、tailscaleを使っているので、それと合わせてアクセス制限は二重化されています

admin