最近はコード自体はほぼ生成A.Iで作成されることが多いと思うけど、ローカルでLLM動かして使えるかどうかやってみた

・参考サイト

https://zenn.dev/mkj/articles/cf8536923d9cd7#discuss

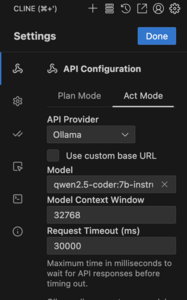

・環境:M4 MacBook Pro 32GBメモリ、ollama、VScode + Cline

・モデルの選択(Alibabaのモデルが限定されらリソースではコーディング目的には一番向いているらしいから)

% ollama pull qwen2.5-coder:7b-instruct

コンソールから動かしてみた感じではなかなかいけてる感じ、Rustは知らないと言われるけどC言語、Python、Golangは扱える

・設定:ollamaを選択、

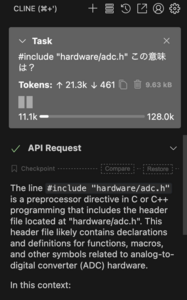

・動かしてみたとこ、

ソースファイルが見つからないと言われるから設定が必要かもしれない

・リソース消費状況

メモリもかなりキツいし、途中でファンも回り出すから、高負荷ではあるからAirでは32GBでもきついかもしれない

ローカルLLMでどこまで使い物になるかやってみる

P.S.

結構タイムアウトするケースが多くて、いまいちollamaとの相性がよくなさそうに思える、コンソールからollama経由でモデル使う方が遥かに安定している

admin