VS codeのCursorからRAG機能の呼び出しうまくいかなかったので、Open WebUIから呼び出しているollamaで動作するLocal LLMにRAG機能を追加してみた

Open WebUIを使えば完全にノーコードでRAG機能が追加できます、でも無論ハルシネーションもでるだろうけど、数年前の知識しかないLocal LLMから見れば大きな進歩だろうと思う

実はOpen WebUIには、ベクターDBもWebクローラー機能(実は内部ではfirecrawlとパイプラインでつながってるとのこと)も実装されてるから実現できるわけですが、チームでの使用とかには荷が重いと思いますが個人で使うならこれで当面は間に合うんじゃないかと思う

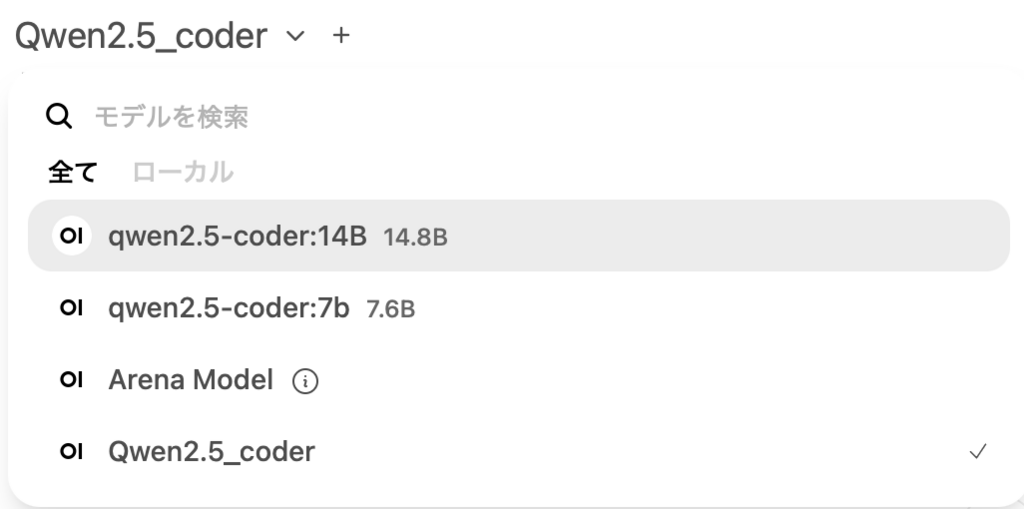

以下のイメージはチャットモードで作成済みのLocal LLM qwen2.5-coder:14B + RAGのモデル(Qwen2.5)がモデル選択メニューから見えてるとこ

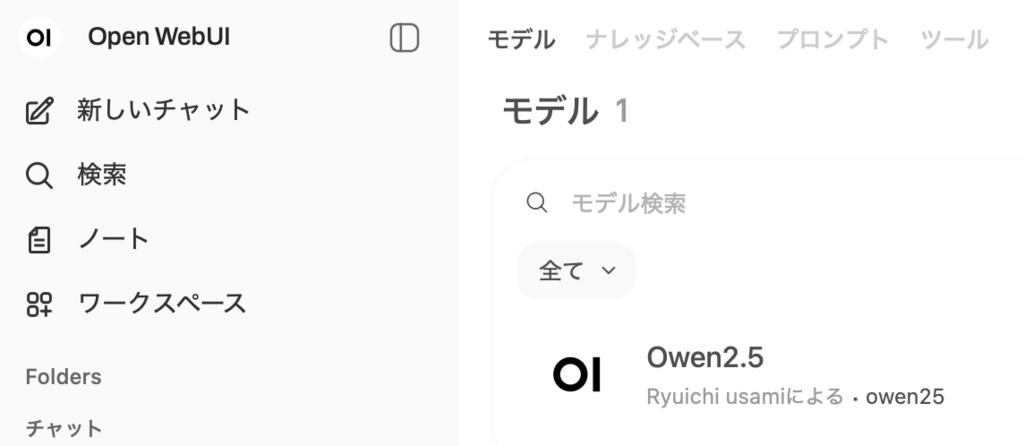

で、このモデルの作り方は、ワークスペースを選択するとこの画面(モデル名はQwenにリネーム前)になります、今現在入力しているのは「モデル」と「ナレッジベース」だけ、プロンプトとツールは必要になった時点で追加します、モデルそのものは画面右上のNew Modelボタンを押して作成します

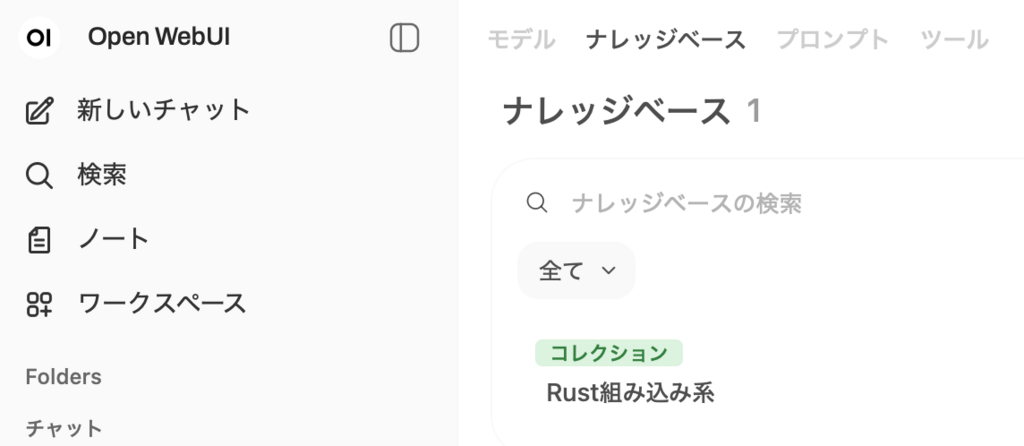

これはすでに作成したナレッジベースですが、

ナレッジの追加は、コレクションの追加メニューで右上の+ボタンを押すと種々の方法で追加できます、ここではwebpageから内部的にはおそらくmarkdown形式で取り込まれてます、これらはgithubから取り込んだmarkdownファイルですね

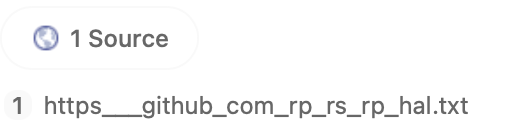

チャット画面で、投げたプロンプトに対して、回答の下部に(1 Source)というのが参考にされたナレッジになります

その部分の拡大は、以下のとおりでmarkdownからの抽出になってますね

しばらくはこの環境でパーソナルエージェント的な使い方をやってみます、違うエージェントが必要になればその時はモデル追加すれば良い、自分が持っているいろんなファイルをぶち込んでしまいたいと思う

P.S. 2026/2/10

Local LLMも分野特化してきていて、例えばqwen2.5-coder:14Bは英語は全くダメ、qwen2.5:14Bはちゃんと使えるから、用途ごとに専門家用意しとく感覚だね

admin