VScodeでcopilotというは安定してるけど、無償だと限度があるから補完的にLocal LLMを使ってみる

<環境>

M4 MacBook Pro/32GB

<手順>

deepseek-coder-v2:latestがそこそこらしいからollamaに追加する

% ollama list

NAME ID SIZE MODIFIED

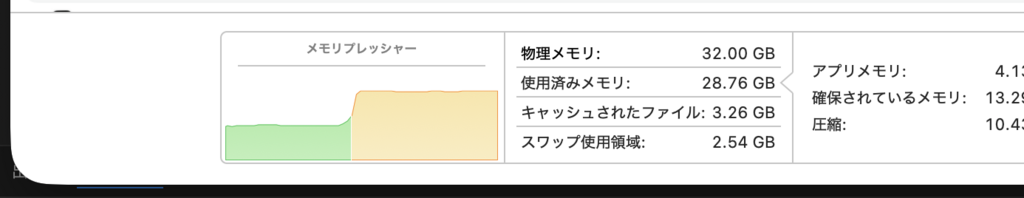

deepseek-coder-v2:latest 63fb193b3a9b 8.9 GB 5 hours ago動かすとメモリは30GB程度消費するからyellow markレベルだけど動作はできる

・ブラウザからの使用

Docker経由が環境を汚染しないからそのやり方で、8080はDcoker内部のportで外部にはport 3000で公開される

% docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:mainDockerでの見え方

・VScodeからの使用

① 拡張機能 Continueをインストールする

② Continueのための設定ファイルを作る

% mkdir -p ~/.continue

code ~/.continue/config.jsonVScodeのエディタが起動するので、以下を入力

{

"models": [

{

"title": "DeepSeek Local",

"provider": "ollama",

"model": "deepseek-coder-v2:latest"

}

],

"defaultModel": "DeepSeek Local"

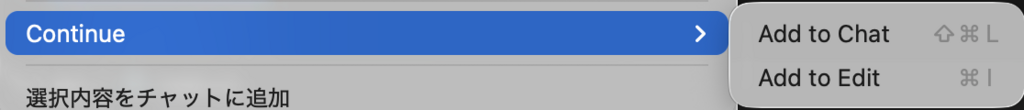

}設定を保存してVScodeを再起動すると、codeの選択 -> 右クリックでContinueのchat/edit起動ができる、Continue自体のwindowsは左側に開く

感覚、まあまあ使えるかなと思う、Rustの組み込みとかはまだ学習レベルが低い感じはあるけどね

admin