tailscale自体はtailnet以外からのアクセスに対しては強固ですが、前の記事で述べた通りいくつか考慮すべきポイントがあります

その中でもクライアント同士(特にユーザクライアントから管理クライアント)でアクセスできてしまうというのは避けなければいけない項目でしょう

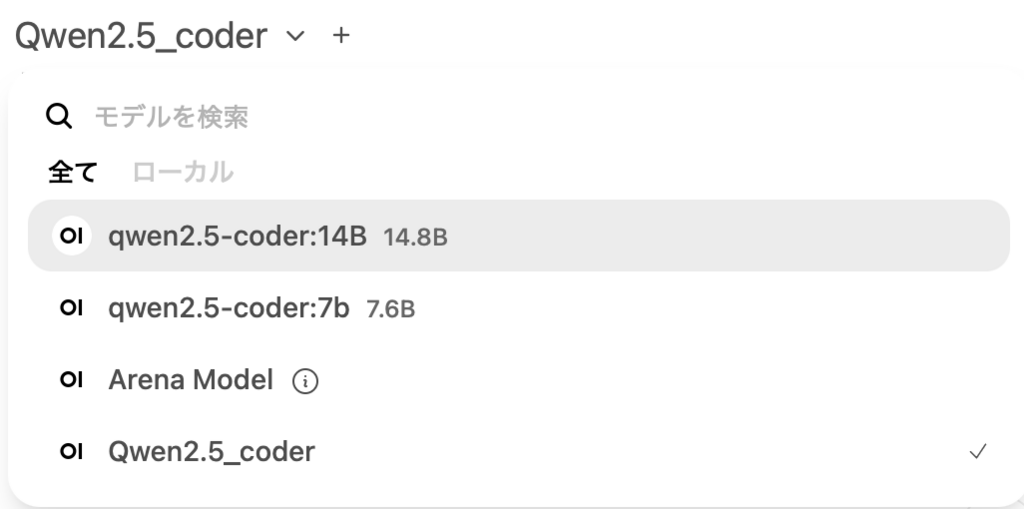

そのための設定がACLです、tailscaleの管理画面で、”Access controls”のjsonファイルに以下のように書き込んで、クライアントからサーバーへのアクセスだけ許可します、ここで許可した以外は全部deny扱いなのでクライアント間は完全分離です

"groups": {

"group:admin": ["user@gmail.com"],

"group:players": ["user@gmail.com"],

},

// Define the tags which can be applied to devices and by which users.

// "tagOwners": {

// "tag:example": ["autogroup:admin"],

// },

"tagOwners": {

"tag:luanti-server": ["group:admin"],

},

// Define grants that govern access for users, groups, autogroups, tags,

// Tailscale IP addresses, and subnet ranges.

"acls": [

{

"action": "accept",

"src": ["group:players"],

"dst": [

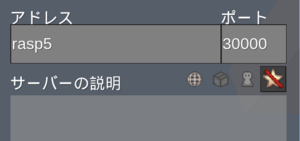

"tag:luanti-server:30000-30010",

"tag:luanti-server:22",

"tag:luanti-server:5901",

],

},

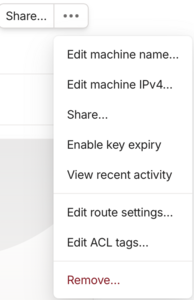

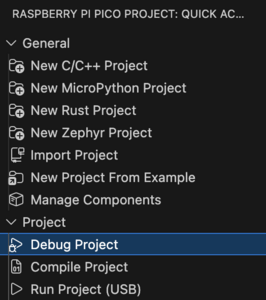

],jsonファイルを編集してセーブすると、Machinesの選択メニューでEdit ACL tagsが現れて、これを選択するとデバイスにタグ付できます

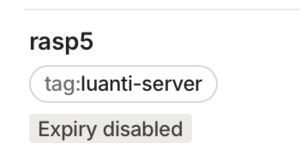

タグ付すると、

のようにmachinesのデバイス名の下にtag表示されるようになりますから、このタグがACL設定の"tag:luanti-server": ["group:admin"]と合致してアクセス(フロー)制御が実行できます

ラズパイ5のufw設定(使うポートだけ許可する)と、unattended-upgradesを使った自動セキュリティアップデートも追加しておきます

tailscaleのfree版だとアクセスの権限制限設定できないけれども、身内の運用ならばあえて管理画面のことは伝えずに運用だね

admin